OpenAI ChatGPT sorprendió al mundo en 2025 con el lanzamiento de GPT-4.1 y sus variantes GPT-4.1 Mini y GPT-4.1 Nano. En particular, GPT-4.1 Mini se posiciona como la versión intermedia de esta familia de modelos, ofreciendo un equilibrio único entre inteligencia, velocidad y costo.

A continuación, exploraremos en detalle qué es GPT-4.1 Mini, cuáles son sus principales características, cómo se compara con otros modelos (tanto de OpenAI como de la competencia) y en qué casos de uso destaca.

Al final, también explicaremos cómo acceder a este modelo, dado su creciente importancia en el panorama de la inteligencia artificial.

¿Qué es GPT-4.1 Mini?

GPT-4.1 Mini es uno de los tres nuevos modelos de lenguaje presentados por OpenAI en abril de 2025. Forma parte de la familia GPT-4.1, que incluye:

- GPT-4.1 (estándar) – el modelo completo, de mayor tamaño y rendimiento.

- GPT-4.1 Mini – la versión intermedia, optimizada para ofrecer un excelente equilibrio entre coste y capacidad.

- GPT-4.1 Nano – la variante más pequeña y rápida, orientada a tareas ligeras con muy baja latencia.

Estos modelos fueron diseñados para sobresalir en tareas de codificación y desarrollo de software, respondiendo a la creciente competencia en el campo de la IA aplicada a programación.

De hecho, OpenAI ha señalado que GPT-4.1 (incluyendo su versión Mini) supera al popular modelo previo GPT-4.0 en casi todas las dimensiones de rendimiento, e incluso mejora algunos aspectos respecto a GPT-4.5. La llegada de GPT-4.1 y sus variantes se venía rumorando durante semanas antes de su lanzamiento, generando expectación sobre sus capacidades avanzadas.

Es importante destacar que, en el momento de su lanzamiento, GPT-4.1 Mini (al igual que sus hermanos) estaba disponible exclusivamente a través de la API de OpenAI, enfocado para uso por desarrolladores. No se podía acceder a este modelo mediante la interfaz web de ChatGPT público inicialmente.

Sin embargo, un mes después, en mayo de 2025, OpenAI comenzó a integrar GPT-4.1 en la aplicación de ChatGPT: los usuarios de la versión gratuita no pueden seleccionarlo manualmente, pero ahora el modelo por defecto para usuarios libres es GPT-4.1 Mini, reemplazando al antiguo GPT-4.0 Mini.

Esto refleja la confianza de OpenAI en las capacidades de GPT-4.1 Mini, al punto de asignarlo para atender al amplio público manteniendo un balance entre calidad y costo.

Principales características de GPT-4.1 Mini

GPT-4.1 Mini se ha ganado rápidamente la atención por ofrecer muchas de las fortalezas del modelo GPT-4.1 completo, pero con mejoras significativas en eficiencia. A continuación, resumimos sus características clave:

Ventana de contexto masiva: Una de las mejoras más notables es que GPT-4.1 Mini admite hasta 1 millón de tokens de contexto. Esto es más de 8 veces el límite de 128 mil tokens de la versión previa GPT-4.0. En términos prácticos, significa que el modelo puede analizar de una sola vez documentos extensos (equivalentes a unas 750 mil palabras) sin necesidad de fragmentarlos o resumirlos previamente. Esta capacidad de contexto largo permite que GPT-4.1 Mini procese historiales de conversación muy prolongados, código fuente de gran tamaño o múltiples documentos legales/científicos integrados, manteniendo la coherencia en sus respuestas incluso con entradas voluminosas.

Alto rendimiento en programación: GPT-4.1 Mini fue afinado específicamente para tareas de codificación y desarrollo de software. Logra resultados sobresalientes en benchmarks de programación. Por ejemplo, alcanza un 54,6% en la prueba SWE-Bench para resolución de problemas de software, superando por amplio margen a GPT-4.0 (que obtenía ~33%). De hecho, GPT-4.1 Mini iguala o supera a GPT-4.0 en muchos puntos de referencia relacionados con código, seguimiento de instrucciones y razonamiento en contextos largos. Los primeros testers reportaron mejoras sustanciales: una empresa informó que GPT-4.1 (modelo completo) resolvió un 60% más de casos en su benchmark de código frente a GPT-4.0, mientras que la versión Mini consigue acercar ese poder con menos recursos. En síntesis, GPT-4.1 Mini es capaz de generar, completar y depurar código con eficacia, siendo ideal como asistente de programación.

Mejor seguimiento de instrucciones y menor tendencia a errores: OpenAI introdujo en GPT-4.1 mejoras en la capacidad de los modelos para seguir instrucciones complejas de forma confiable. GPT-4.1 Mini hereda estas mejoras, destacándose en pruebas como MultiChallenge de seguimiento de instrucciones donde obtiene resultados aproximadamente 10,5 puntos porcentuales mejores que GPT-4.0. En la práctica, esto significa que el modelo entiende y ejecuta mejor indicaciones paso a paso, requisitos de formato específicos (por ejemplo, respetar estructuras JSON, XML, etc.) y condiciones del tipo “no respondas si…”. Asimismo, se redujeron drásticamente las alucinaciones y respuestas incoherentes: las pruebas internas mostraron que las ediciones de código erróneas bajaron del 9% con GPT-4.0 a solo 2% con GPT-4.1. Para el usuario, GPT-4.1 Mini ofrece respuestas más fiables, con menos necesidad de reintentar prompts o corregir salidas formateadas incorrectamente.

Latencia mejorada (mayor velocidad): A medida que los modelos crecen en tamaño, suelen volverse más lentos al responder. Sin embargo, GPT-4.1 Mini está diseñado para ser más rápido que sus contrapartes mayores. De hecho, la familia GPT-4.1 introdujo optimizaciones que logran que los nuevos modelos respondan hasta un 40% más rápido que GPT-4.0 en promedio. En el caso de GPT-4.1 Mini, su menor tamaño relativo implica aún menor latencia, haciéndolo ideal para aplicaciones interactivas en las que el tiempo de respuesta es crítico. OpenAI señala que GPT-4.1 Mini prácticamente reduce a la mitad la latencia respecto al antiguo GPT-4.0 Mini, sin sacrificar demasiada capacidad cognitiva. En resumen, ofrece respuestas casi en tiempo real para muchas tareas, mejorando la experiencia de usuario en chats y herramientas dinámicas.

Costo significativamente reducido: Uno de los mayores atractivos de GPT-4.1 Mini es su menor costo de uso en comparación con el modelo completo. Según los precios de la API de OpenAI, utilizar GPT-4.1 Mini cuesta aproximadamente 0,40 USD por millón de tokens de entrada y 1,60 USD por millón de tokens generados. Esto es cinco veces más barato que GPT-4.1 estándar (cuya tarifa es ~2 USD por millón de tokens de entrada y ~8 USD por millón de salida). En otras palabras, GPT-4.1 Mini permite un ahorro de alrededor del 80% en costes frente al modelo mayor para la misma cantidad de texto procesado. OpenAI incluso ofrece opciones para abaratar más el uso, como descuentos por batching (procesamiento por lotes) o reutilización de prompts en caché, lo que puede reducir a la mitad adicional el gasto en ciertos escenarios. Gracias a este bajo costo, GPT-4.1 Mini resulta muy atractivo para aplicaciones de alto volumen de peticiones o para startups con presupuesto limitado, ya que brinda inteligencia casi de nivel GPT-4 a precio sustancialmente menor.

Capacidades multimodales avanzadas: Al igual que la versión completa, GPT-4.1 Mini no solo trabaja con texto, sino que también maneja entradas visuales. La familia GPT-4.1 mejoró las funciones multimodales introducidas en GPT-4, logrando interpretar imágenes complejas, gráficos e incluso contenido de video largo. Por ejemplo, en pruebas especializadas GPT-4.1 pudo analizar videos de 30 a 60 minutos sin subtítulos y responder preguntas sobre su contenido con precisión. También demuestra un rendimiento destacado describiendo imágenes o entendiendo diagramas científicos y matemáticos. Esto convierte a GPT-4.1 Mini en un asistente versátil capaz de razonar sobre texto, código, imágenes y más. Si bien GPT-4.1 Mini tiene un poco menos de “capacidad intelectual” que la versión completa, mantiene estas habilidades multimodales, expandiendo los posibles casos de uso (por ejemplo, resumir largos videos informativos, analizar contenido visual dentro de documentos, etc.) con un costo menor.

Conocimiento actualizado: Otra mejora importante es la actualización del corte de conocimiento del modelo. GPT-4.1 fue entrenado con información más reciente que sus predecesores, llevando la fecha de conocimiento hasta junio de 2024. En contraste, GPT-4.0 manejaba datos principalmente hasta 2021. Esto significa que GPT-4.1 Mini tiene conciencia de eventos, librerías de código, tendencias y hechos más recientes (hasta mediados de 2024), lo que se traduce en respuestas más relevantes y actualizadas en temas técnicos o de actualidad. Para desarrolladores, implica que GPT-4.1 Mini “sabe” de tecnologías y versiones de software más nuevas, reduciendo la necesidad de complementar sus respuestas con contextos adicionales sobre hechos posteriores a 2021.

Diferencias frente a otros modelos de OpenAI

Como parte de la nueva familia de modelos, GPT-4.1 Mini se distingue claramente tanto de los modelos anteriores de OpenAI como de sus hermanos de la generación 4.1. A continuación, resumimos las diferencias clave:

- GPT-4.1 (Completo) vs GPT-4.1 Mini: La versión estándar GPT-4.1 es el modelo más grande y potente lanzado en 2025 por OpenAI, orientado a tareas extremadamente exigentes. GPT-4.1 Mini, por su parte, ofrece casi las mismas capacidades que la versión completa en muchos escenarios habituales, pero con menor latencia y costo. En benchmarks de codificación e instrucciones, GPT-4.1 Mini iguala o supera lo logrado por GPT-4.0, el modelo más usado anteriormente. La contrapartida es que GPT-4.1 Mini puede rendir ligeramente por debajo de GPT-4.1 completo en tareas muy especializadas o de máxima complejidad, debido a que es un modelo más pequeño. Aun así, en la mayoría de aplicaciones prácticas la diferencia de calidad es mínima, mientras que la diferencia en costo es significativa. Por este motivo, muchos desarrolladores encontrarán que GPT-4.1 Mini brinda mejor relación costo-beneficio para integrar IA en sus productos. De hecho, OpenAI ha declarado que GPT-4.1 ofrece resultados similares o mejores que GPT-4.5 pero de forma más eficiente, al punto de planear la retirada del modelo GPT-4.5 a mediados de 2025 para concentrar recursos en 4.1.

- GPT-4.1 Mini vs GPT-4.1 Nano: GPT-4.1 Nano es la versión “ultraligera” de esta serie. Sacrifica algo de capacidad de razonamiento a cambio de máxima velocidad y mínimo costo. Nano está pensado para dispositivos con recursos limitados (por ejemplo, aplicaciones móviles, dispositivos edge IoT) o casos donde la baja latencia es prioritaria. Comparado con Mini, el modelo Nano es aún más barato (solo $0.10 por millón de tokens de entrada, $0.40 por millón de salida) pero su rendimiento en tareas complejas es menor. Aun así, sorprende que incluso el diminuto GPT-4.1 Nano soporta el millón de tokens de contexto completo al igual que sus hermanos. En resumen, GPT-4.1 Nano es ideal para automatizaciones sencillas, chatbots de consultas frecuentes o autocompletado, mientras que GPT-4.1 Mini cubre un punto medio: es suficientemente capaz para tareas avanzadas, pero manteniendo buena velocidad y costo moderado.

- Comparativa con GPT-4.0 y GPT-3.5: GPT-4.1 Mini supone un salto generacional respecto a los modelos de la era GPT-4.0 (también llamado GPT-4o). Por ejemplo, GPT-4.1 Mini supera a GPT-4.0 en casi todos los indicadores de desempeño medidos por OpenAI. Tiene una ventana de contexto mucho mayor (1M vs 128K tokens), es más rápido y su entrenamiento adicional le permite seguir instrucciones complejas con mucha más fidelidad. Incluso en tareas no específicas de código, GPT-4.1 Mini demuestra mayor inteligencia general (score más alto en pruebas multilingües MMLU) que GPT-4.0, acercándose al nivel de GPT-4.5 En cuanto a GPT-3.5 (el motor detrás de ChatGPT original), la diferencia es aún más amplia: GPT-4.1 Mini maneja información más actualizada y realiza razonamientos que GPT-3.5 no alcanzaba, reduciendo sustancialmente las alucinaciones y errores de contexto largo. Por estas razones, OpenAI ha reemplazado internamente al antiguo GPT-4.0 Mini por GPT-4.1 Mini como modelo por defecto para muchas aplicaciones.

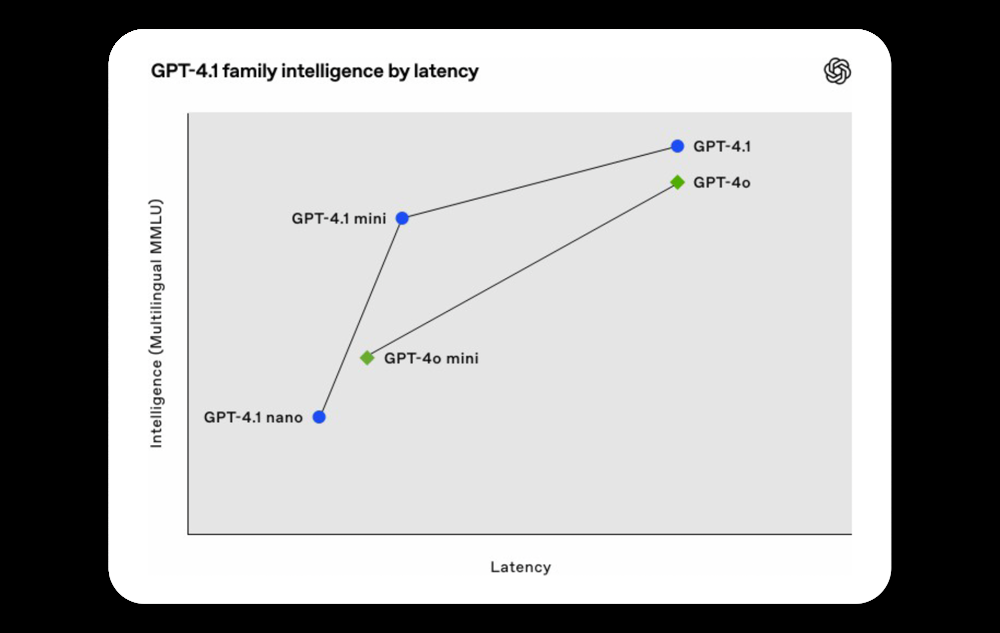

Figura: Gráfica comparativa de la familia GPT-4.1 en términos de inteligencia (eje vertical, medido en desempeño multilingüe MMLU) versus latencia (eje horizontal).

Se observa que GPT-4.1 Mini (punto azul) alcanza un nivel de inteligencia casi tan alto como el modelo GPT-4.1 completo (punto azul en la parte superior derecha), pero con menor latencia (más hacia la izquierda).

En contraste, GPT-4.1 Nano (punto azul en la esquina inferior izquierda) presenta la latencia más baja pero con rendimiento inferior.

El modelo de la generación previa GPT-4.0 Mini (rombo verde) queda notablemente por debajo de GPT-4.1 Mini en capacidad cognitiva, a pesar de tener una latencia similar, evidenciando la mejora generacional aportada por GPT-4.1

- Frente a otros competidores (Claude, Gemini, etc.): En el panorama de IA general, GPT-4.1 (y Mini) han llegado para ayudar a OpenAI a mantener su liderazgo frente a rivales como Anthropic y Google. Un factor diferenciador clave es el contexto de 1 millón de tokens: por ejemplo, Claude 3 de Anthropic maneja alrededor de 200 mil tokens, considerablemente menos que GPT-4.1. Google, por su parte, planea modelos como Gemini 1.5 con contextos similares a 1 M de tokens, pero aún en fase preliminar. Además, OpenAI ofrece variantes Mini y Nano, lo que proporciona flexibilidad para distintos casos de uso y presupuestos que los competidores aún no igualan. En costo, GPT-4.1 Mini resulta muy competitivo; por ejemplo, los modelos de Anthropic tienden a ser más costosos por token procesado para un rendimiento equivalente. En resumen, GPT-4.1 Mini destaca por combinar un contexto ultra-largo y alto rendimiento técnico con un costo accesible, algo crucial para desarrolladores que evalúan distintas opciones de IA.

Casos de uso ideales para GPT-4.1 Mini

Debido a su combinación de inteligencia, rapidez y bajo costo, GPT-4.1 Mini resulta atractivo en una amplia variedad de escenarios de uso. Algunos de los casos donde brilla especialmente son:

- Asistentes de programación y herramientas de desarrollo: GPT-4.1 Mini es lo suficientemente potente para integrarse en IDEs o editores de código como asistente que sugiere autocompletados inteligentes, detecta errores o genera fragmentos de código a partir de instrucciones en lenguaje natural. Empresas de software pueden usarlo en herramientas internas de apoyo a desarrolladores, obteniendo sugerencias de implementación, explicaciones de funciones e incluso generación de documentación técnica a partir del código. Gracias a su gran contexto, puede leer y comprender archivos extensos de código o documentación y dar feedback unificado.

- Chatbots conversacionales y atención al cliente: Para construir chatbots avanzados que den soporte a clientes o usuarios, GPT-4.1 Mini es una elección excelente. Tiene la capacidad suficiente para entender preguntas complejas, seguir el hilo de conversaciones largas y proporcionar respuestas matizadas, todo sin incurrir en los costos elevados de un modelo máximo. Por ejemplo, en un chatbot de soporte técnico, GPT-4.1 Mini puede guiar al usuario en resolución de problemas basándose en manuales técnicos largos cargados en su contexto (que puede alcanzar cientos de páginas). Su velocidad también garantiza que las respuestas se entreguen rápidamente, mejorando la experiencia de usuario en interacciones de servicio al cliente.

- Análisis de documentos extensos y resúmenes: En sectores como el legal, médico o investigación científica, a menudo es necesario analizar grandes cantidades de texto (contratos, historiales clínicos, artículos académicos). GPT-4.1 Mini puede ingerir un documento extremadamente largo o incluso un conjunto de documentos (gracias al contexto de 1M tokens) y responder preguntas específicas o generar resúmenes ejecutivos fieles al contenido. Un caso de uso concreto es la revisión de documentación legal: GPT-4.1 Mini podría leer completo un contrato de cientos de páginas y extraer cláusulas clave o inconsistencias. Su menor costo por token permite realizar estas tareas de análisis a gran escala de manera más asequible que antes, lo cual es valioso para despachos legales o departamentos de compliance. En medicina, podría sintetizar información relevante de expedientes clínicos voluminosos para apoyar diagnósticos o investigaciones.

- Asistentes personales con amplio contexto: GPT-4.1 Mini es ideal para construir asistentes digitales que necesiten recordar largas conversaciones o grandes bases de conocimiento proporcionadas por el usuario. Por ejemplo, un asistente de proyecto podría almacenar en el contexto todos los correos y notas de un equipo (hasta cientos de miles de palabras) y permitir consultas del tipo “¿qué se decidió la semana pasada sobre X tema?”. La versión Mini tiene la inteligencia suficiente para interpretar esas consultas en contexto, y su rendimiento rápido asegura que dichas consultas tengan respuestas casi inmediatas. Muchas aplicaciones SaaS de nueva generación están integrando GPT-4.1 Mini en segundo plano para brindar funcionalidades de búsqueda semántica, resumen de cambios o chat con datos internos, beneficiándose de que es lo bastante rápido para interacciones en vivo y lo bastante inteligente para extraer información útil de un mar de datos.

- Plataformas educativas y de contenidos: Otra área de oportunidad son los sistemas educativos personalizados. GPT-4.1 Mini puede ser aprovechado en plataformas de e-learning para brindar explicaciones bajo demanda, corregir ejercicios de programación de estudiantes, o incluso generar contenido educativo adaptado al contexto del alumno. Gracias a su costo bajo, es viable emplearlo de forma masiva para muchos usuarios simultáneamente. Asimismo, creadores de contenido podrían usar GPT-4.1 Mini para generar borradores de artículos, análisis de tendencias (ingiriendo reportes completos y obteniendo conclusiones), o moderar comunidades analizando conversaciones largas en foros/redes sociales para resumir discusiones.

En términos generales, GPT-4.1 Mini se recomienda en proyectos que requieran un equilibrio entre capacidad y eficiencia. Si una tarea es muy sencilla o requiere respuestas instantáneas en dispositivos muy limitados, quizá GPT-4.1 Nano sea suficiente.

Si, por el contrario, se enfrenta a un desafío extremadamente complejo (por ejemplo, resolver problemas científicos inéditos o proyectos de código muy sofisticados), tal vez valga la pena invertir en el modelo GPT-4.1 completo.

Pero para la gran mayoría de aplicaciones prácticas –desde asistentes conversacionales hasta análisis de datos– GPT-4.1 Mini ofrece potencia de sobra a un costo y velocidad sumamente ventajosos.

No es casualidad que OpenAI lo haya adoptado como modelo por defecto para los usuarios gratuitos de ChatGPT en 2025, lo que demuestra que incluso para un uso general amplio, GPT-4.1 Mini cumple con creces manteniendo los costos controlados.

¿Cómo acceder a GPT-4.1 Mini?

Actualmente, el acceso a GPT-4.1 Mini se realiza principalmente a través de la API de OpenAI. Para utilizar este modelo, es necesario disponer de una cuenta de desarrollador de OpenAI con créditos o suscripción adecuada, y hacer llamadas a la API especificando el motor gpt-4.1-mini como modelo elegido.

OpenAI ha puesto a disposición la documentación técnica actualizada que detalla cómo integrar GPT-4.1 (y sus variantes Mini y Nano) en diversos entornos de desarrollo.

En la API, los desarrolladores pueden ajustar parámetros como el número máximo de tokens de respuesta (hasta 32 768 tokens de salida por consulta en el caso de GPT-4.1 Mini), temperatura, etc., igual que con otros modelos de la plataforma.

Algunos puntos a tener en cuenta para acceder y usar GPT-4.1 Mini:

- Disponibilidad en ChatGPT: Como se mencionó, GPT-4.1 Mini no aparecía inicialmente como opción directa en la interfaz de ChatGPT para usuarios. Sin embargo, OpenAI migró la infraestructura de ChatGPT Free a GPT-4.1 Mini por defecto, por lo que los usuarios gratuitos hoy están indirectamente usando este modelo. Los suscriptores de ChatGPT Plus posiblemente tengan acceso al modelo GPT-4.1 estándar o a GPT-4.5 (si aún está disponible) en la interfaz, pero no a la variante Mini de forma separada. OpenAI podría habilitar en el futuro la selección explícita de GPT-4.1 Mini en su UI, pero por ahora la vía oficial es la API.

- Uso mediante API y SDKs: Para empezar a usar GPT-4.1 Mini, basta con obtener una API key de OpenAI e invocar a los endpoints de chat completions o completions normales indicando el modelo deseado. Por ejemplo, usando la librería de Python

openai, se llama conmodel="gpt-4.1-mini". Cabe señalar que las llamadas a la API de GPT-4.1 Mini tienen un costo significativamente menor que las de GPT-4.1 completo (como vimos en la sección de costos), lo que es una grata noticia para desarrolladores preocupados por el presupuesto. OpenAI mantiene límites de tasa (rate limits) que pueden variar según el nivel de acceso del usuario, pero generalmente GPT-4.1 Mini, al ser más ligero, puede tener una tasa de respuesta mayor permitida que el modelo completo. - Documentación y mejores prácticas: Dado que GPT-4.1 Mini es un modelo nuevo, OpenAI ha publicado guías de uso y best practices para obtener el máximo provecho. Muchas de estas recomendaciones son similares a las de GPT-4: por ejemplo, aprovechar el gran contexto para suministrar instrucciones claras y contexto suficiente en cada solicitud, manejar adecuadamente la paginación de resultados cuando se procesan documentos extensos, y controlar la temperatura del modelo según se requiera creatividad o precisión. Además, se puede ajustar finamente (fine-tune) GPT-4.1 Mini con datos propios, ya que OpenAI abrió la opción de fine-tuning desde el día del lanzamiento. Esto permite entrenar la versión Mini en un tono o dominio específico, haciendo al modelo aún más útil en entornos de producción especializados.

- Plataformas de terceros: Varias plataformas de IA de terceros están integrando GPT-4.1 Mini para ofrecer sus capacidades sin requerir programación por parte del usuario final. Por ejemplo, algunas herramientas en línea de chat conversacional o asistentes en navegadores han anunciado soporte para GPT-4.1 Mini. Asegúrate de verificar la legitimidad y políticas de privacidad de dichos servicios antes de usarlos, pero es bueno saber que existen alternativas para probar GPT-4.1 Mini de forma rápida. No obstante, la forma más directa y completa de uso es vía la API oficial de OpenAI, ya que te brinda control total sobre los parámetros, el contexto y la integración en tus propias aplicaciones.

En conclusión, acceder a GPT-4.1 Mini requiere un pequeño paso adicional (crear una cuenta de desarrollador o utilizar plataformas especializadas), pero las recompensas en términos de funcionalidad y eficiencia valen la pena.

Este modelo abre nuevas posibilidades para incorporar IA de alto nivel en proyectos grandes y pequeños, democratizando el acceso a herramientas avanzadas de lenguaje.

Conclusiones

GPT-4.1 Mini representa un hito en la evolución de los modelos de lenguaje de OpenAI: logra un punto óptimo entre potencia y eficiencia que antes no estaba disponible.

Con una ventana de contexto gigantesca, un desempeño notable en código y comprensión de instrucciones, y costos de uso mucho más bajos, este modelo permite que tanto desarrolladores independientes como grandes empresas aprovechen capacidades de IA avanzada sin arruinarse en el intento.

Su lanzamiento también indica una estrategia interesante por parte de OpenAI, ofreciendo modelos escalonados (completo, mini, nano) para adaptarse a diferentes necesidades, lo que facilita la integración de IA en todo tipo de productos y servicios.

La rápida adopción de GPT-4.1 Mini (incluso como modelo base para ChatGPT gratuito) demuestra la confianza en su rendimiento robusto y confiable.

En poco tiempo, se ha convertido en una herramienta clave para quienes trabajan con procesamiento de lenguaje natural, desarrollo de software asistido por IA, análisis de datos extensos y muchas otras áreas.

Además, al obligar a la competencia a ponerse al día, su aparición beneficia al ecosistema en general, marcando un estándar en cuanto a cuánto contexto y calidad se puede ofrecer a bajo costo.

Mirando hacia el futuro, OpenAI ya ha insinuado que continuará expandiendo su línea de modelos con nuevas versiones (se habla de próximos modelos “o3” y “o4-mini”, entre otros).

Pero GPT-4.1 Mini seguramente mantendrá su relevancia durante un buen tiempo, dado que cubre una necesidad evidente en el mercado: IA poderosa, rápida y asequible.

Para cualquier persona interesada en inteligencia artificial aplicada, GPT-4.1 Mini es un referente obligado en 2025, y un modelo que ejemplifica cómo la IA puede volverse más accesible y útil sin comprometer la calidad.

En resumen, GPT-4.1 Mini consolida la visión de OpenAI de llevar sus tecnologías a un público más amplio.

Si buscas incorporar IA generativa en tu proyecto o negocio, vale la pena considerar lo que GPT-4.1 Mini ofrece: la inteligencia de los mejores modelos de la actualidad, empaquetada en una forma eficiente y orientada a la realidad de las aplicaciones del mundo real.

El resultado es una inteligencia artificial de última generación lista para usar en el día a día, abriendo paso a innovaciones antes reservadas solo para quienes podían costear los modelos más grandes. ¡El futuro de la IA pinta prometedor, con GPT-4.1 Mini y sus sucesores liderando el camino!